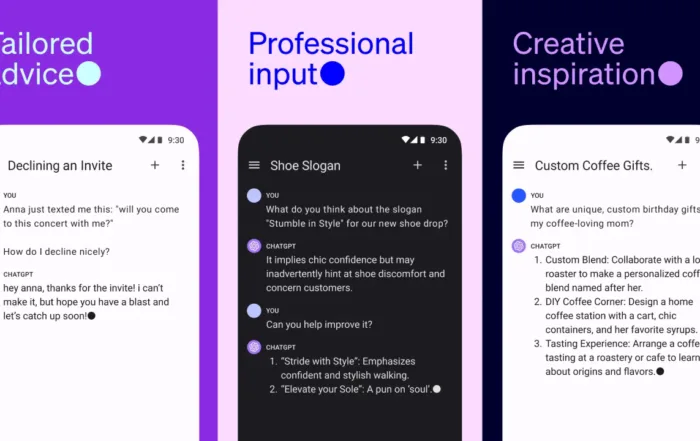

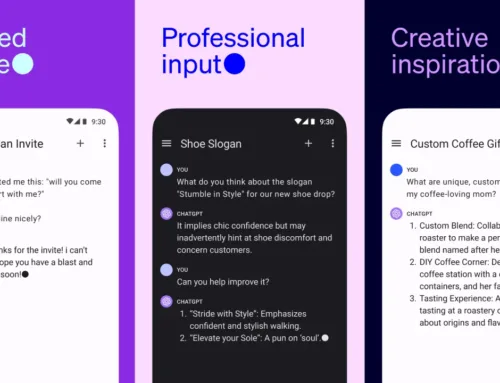

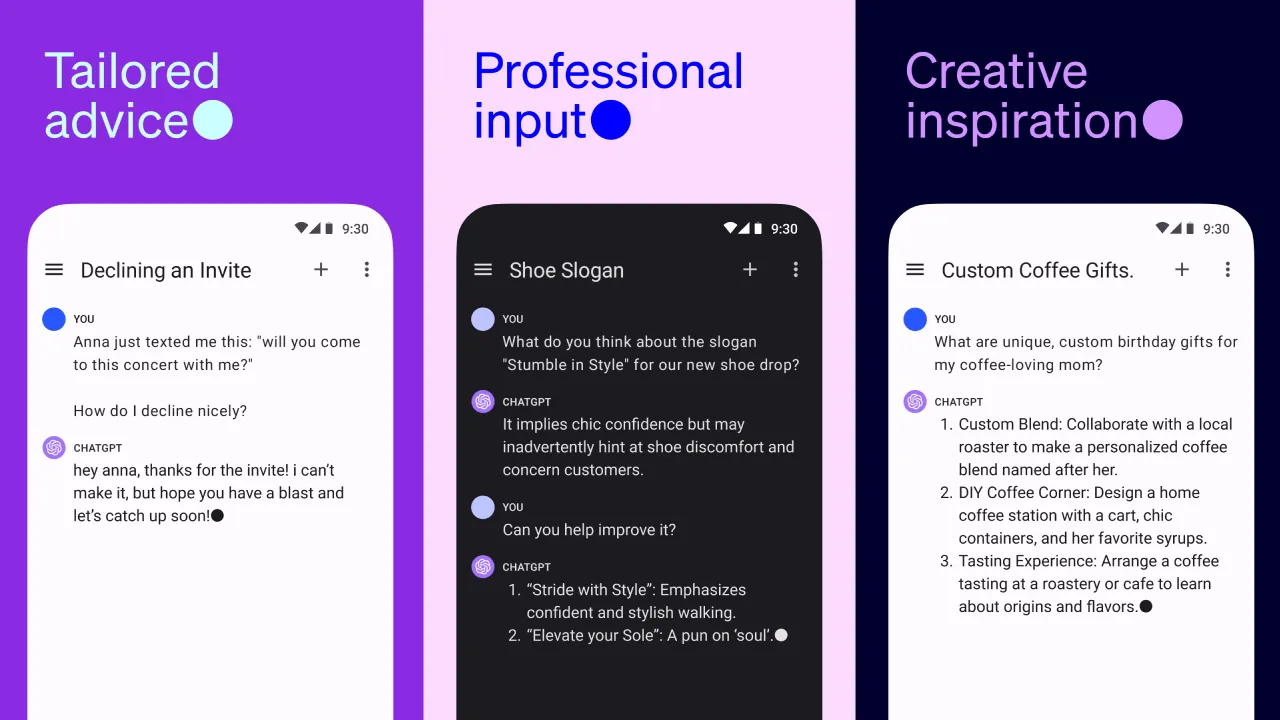

Oggi Meta ha annunciato una nuova serie di modelli di intelligenza artificiale, chiamati Llama 2, progettati per poter creare applicazioni simili a ChatGPT di OpenAI, Bing Chat e altri moderni chatbot. Allenato usando dati pubblicamente disponibili, Meta sostiene che le prestazioni di Llama 2 sono molto migliori della generazione precedente di modelli Llama.

Llama 2 è il successore di Llama, una collezione di modelli in grado di generare testo e codice in risposta a domande, simile ad altri sistemi chatbot, disponibile gratuitamente per uso commerciale e di ricerca, sarà disponibile per il fine-tuning sulle piattaforme di hosting di modelli di intelligenza artificiale come AWS, Azure e Hugging Face.

Inoltre, Meta sostiene che Llama 2 sarà più facile da eseguire, ottimizzato per Windows grazie ad una partnership ampliata con Microsoft, nonché per smartphone e PC equipaggiati con il sistema-on-chip Snapdragon di Qualcomm. (Qualcomm afferma di lavorare per portare Llama 2 su dispositivi Snapdragon nel 2024.)

Llama 2 è disponibile in due versioni, Llama 2 e Llama 2-Chat, quest’ultima ottimizzata per le conversazioni. Sia Llama 2 che Llama 2-Chat sono ulteriormente suddivisi in versioni di varia complessità: 7 miliardi di parametri, 13 miliardi di parametri e 70 miliardi di parametri. (“Parametri” sono le parti di un modello apprese dai dati di allenamento e definiscono effettivamente le capacità del modello nel generare testo).

Il modello Llama 2 è stato allenato su due milioni di token e viene suddiviso in diverse versioni a seconda della complessità, Meta non rivela da dove provengono i dati che hanno usato per allenare il modello, affermano solo che questi dati provengono dal web e principalmente in lingua inglese, e che non provengono dai propri prodotti o servizi.

Probabilmente, la riluttanza a divulgare dettagli di addestramento è motivata non solo da ragioni di concorrenza, ma anche dalle controversie legali che circondano l’intelligenza artificiale generativa. Proprio oggi, migliaia di autori hanno firmato una lettera che esorta le aziende tecnologiche a smettere di utilizzare le proprie scritture per l’addestramento dei modelli di intelligenza artificiale senza autorizzazione o compensazione.

Tuttavia, afferma Meta, basandosi su una serie di benchmark, i modelli Llama 2 hanno prestazioni leggermente inferiori rispetto ai rivali più noti e chiusi, GPT-4 e PaLM 2, con Llama 2 che è significativamente indietro rispetto a GPT-4 nella programmazione informatica. Tuttavia, secondo Meta, gli utenti trovano Llama 2 approssimativamente altrettanto “utile” come ChatGPT; Llama 2 ha risposto allo stesso modo in un insieme di circa 4.000 prompt progettati per valutare la “utilità” e la “sicurezza”.

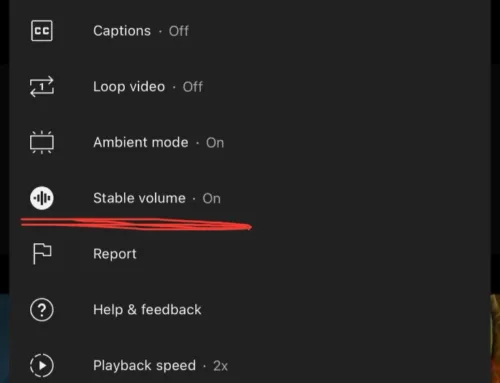

È possibile utilizzare Llama 2 dal proprio pc tramite il software KoboldCPP da questo github scaricate il software dalla sezione release, questo software utilizza principalmente la vostra cpu e ram per generare il testo, ma è possibile anche dedicare una certa quantità di memoria VRAM della vostra scheda video per alleggerire il carico sulla ram e accelerare la velocità di generazione del testo.

KoboldCPP fa uso dei modelli convertiti in GGML, ecco una lista di modelli Llama 2 per GGML, in genere il modello 7B (7 miliardi di parametri) richiede circa 6-8 GB di ram mentre il modello 13B richiede circa 9-12 GB di ram, i modelli ancora più grandi richiedono enormi quantità di memoria ram.

Meta ammette che Llama 2 presenta alcuni bias e bias tossici, ma sta lavorando per minimizzarli tramite servizi di sicurezza. In definitiva, Meta incoraggia l’uso responsabile di Llama 2 e chiede agli utenti di rispettare i termini della licenza e le linee guida di utilizzo accettabile.

Canale Telegram Offerte

Articoli Recenti

Oggi Meta ha annunciato una nuova serie di modelli di intelligenza artificiale, chiamati Llama 2, progettati per poter creare applicazioni simili a ChatGPT di OpenAI, Bing Chat e altri moderni chatbot. Allenato usando dati pubblicamente disponibili, Meta sostiene che le prestazioni di Llama 2 sono molto migliori della generazione precedente di modelli Llama.

Llama 2 è il successore di Llama, una collezione di modelli in grado di generare testo e codice in risposta a domande, simile ad altri sistemi chatbot, disponibile gratuitamente per uso commerciale e di ricerca, sarà disponibile per il fine-tuning sulle piattaforme di hosting di modelli di intelligenza artificiale come AWS, Azure e Hugging Face.

Inoltre, Meta sostiene che Llama 2 sarà più facile da eseguire, ottimizzato per Windows grazie ad una partnership ampliata con Microsoft, nonché per smartphone e PC equipaggiati con il sistema-on-chip Snapdragon di Qualcomm. (Qualcomm afferma di lavorare per portare Llama 2 su dispositivi Snapdragon nel 2024.)

Llama 2 è disponibile in due versioni, Llama 2 e Llama 2-Chat, quest’ultima ottimizzata per le conversazioni. Sia Llama 2 che Llama 2-Chat sono ulteriormente suddivisi in versioni di varia complessità: 7 miliardi di parametri, 13 miliardi di parametri e 70 miliardi di parametri. (“Parametri” sono le parti di un modello apprese dai dati di allenamento e definiscono effettivamente le capacità del modello nel generare testo).

Il modello Llama 2 è stato allenato su due milioni di token e viene suddiviso in diverse versioni a seconda della complessità, Meta non rivela da dove provengono i dati che hanno usato per allenare il modello, affermano solo che questi dati provengono dal web e principalmente in lingua inglese, e che non provengono dai propri prodotti o servizi.

Probabilmente, la riluttanza a divulgare dettagli di addestramento è motivata non solo da ragioni di concorrenza, ma anche dalle controversie legali che circondano l’intelligenza artificiale generativa. Proprio oggi, migliaia di autori hanno firmato una lettera che esorta le aziende tecnologiche a smettere di utilizzare le proprie scritture per l’addestramento dei modelli di intelligenza artificiale senza autorizzazione o compensazione.

Tuttavia, afferma Meta, basandosi su una serie di benchmark, i modelli Llama 2 hanno prestazioni leggermente inferiori rispetto ai rivali più noti e chiusi, GPT-4 e PaLM 2, con Llama 2 che è significativamente indietro rispetto a GPT-4 nella programmazione informatica. Tuttavia, secondo Meta, gli utenti trovano Llama 2 approssimativamente altrettanto “utile” come ChatGPT; Llama 2 ha risposto allo stesso modo in un insieme di circa 4.000 prompt progettati per valutare la “utilità” e la “sicurezza”.

È possibile utilizzare Llama 2 dal proprio pc tramite il software KoboldCPP da questo github scaricate il software dalla sezione release, questo software utilizza principalmente la vostra cpu e ram per generare il testo, ma è possibile anche dedicare una certa quantità di memoria VRAM della vostra scheda video per alleggerire il carico sulla ram e accelerare la velocità di generazione del testo.

KoboldCPP fa uso dei modelli convertiti in GGML, ecco una lista di modelli Llama 2 per GGML, in genere il modello 7B (7 miliardi di parametri) richiede circa 6-8 GB di ram mentre il modello 13B richiede circa 9-12 GB di ram, i modelli ancora più grandi richiedono enormi quantità di memoria ram.

Meta ammette che Llama 2 presenta alcuni bias e bias tossici, ma sta lavorando per minimizzarli tramite servizi di sicurezza. In definitiva, Meta incoraggia l’uso responsabile di Llama 2 e chiede agli utenti di rispettare i termini della licenza e le linee guida di utilizzo accettabile.

Articoli Recenti

Oggi Meta ha annunciato una nuova serie di modelli di intelligenza artificiale, chiamati Llama 2, progettati per poter creare applicazioni simili a ChatGPT di OpenAI, Bing Chat e altri moderni chatbot. Allenato usando dati pubblicamente disponibili, Meta sostiene che le prestazioni di Llama 2 sono molto migliori della generazione precedente di modelli Llama.

Llama 2 è il successore di Llama, una collezione di modelli in grado di generare testo e codice in risposta a domande, simile ad altri sistemi chatbot, disponibile gratuitamente per uso commerciale e di ricerca, sarà disponibile per il fine-tuning sulle piattaforme di hosting di modelli di intelligenza artificiale come AWS, Azure e Hugging Face.

Inoltre, Meta sostiene che Llama 2 sarà più facile da eseguire, ottimizzato per Windows grazie ad una partnership ampliata con Microsoft, nonché per smartphone e PC equipaggiati con il sistema-on-chip Snapdragon di Qualcomm. (Qualcomm afferma di lavorare per portare Llama 2 su dispositivi Snapdragon nel 2024.)

Llama 2 è disponibile in due versioni, Llama 2 e Llama 2-Chat, quest’ultima ottimizzata per le conversazioni. Sia Llama 2 che Llama 2-Chat sono ulteriormente suddivisi in versioni di varia complessità: 7 miliardi di parametri, 13 miliardi di parametri e 70 miliardi di parametri. (“Parametri” sono le parti di un modello apprese dai dati di allenamento e definiscono effettivamente le capacità del modello nel generare testo).

Il modello Llama 2 è stato allenato su due milioni di token e viene suddiviso in diverse versioni a seconda della complessità, Meta non rivela da dove provengono i dati che hanno usato per allenare il modello, affermano solo che questi dati provengono dal web e principalmente in lingua inglese, e che non provengono dai propri prodotti o servizi.

Probabilmente, la riluttanza a divulgare dettagli di addestramento è motivata non solo da ragioni di concorrenza, ma anche dalle controversie legali che circondano l’intelligenza artificiale generativa. Proprio oggi, migliaia di autori hanno firmato una lettera che esorta le aziende tecnologiche a smettere di utilizzare le proprie scritture per l’addestramento dei modelli di intelligenza artificiale senza autorizzazione o compensazione.

Tuttavia, afferma Meta, basandosi su una serie di benchmark, i modelli Llama 2 hanno prestazioni leggermente inferiori rispetto ai rivali più noti e chiusi, GPT-4 e PaLM 2, con Llama 2 che è significativamente indietro rispetto a GPT-4 nella programmazione informatica. Tuttavia, secondo Meta, gli utenti trovano Llama 2 approssimativamente altrettanto “utile” come ChatGPT; Llama 2 ha risposto allo stesso modo in un insieme di circa 4.000 prompt progettati per valutare la “utilità” e la “sicurezza”.

È possibile utilizzare Llama 2 dal proprio pc tramite il software KoboldCPP da questo github scaricate il software dalla sezione release, questo software utilizza principalmente la vostra cpu e ram per generare il testo, ma è possibile anche dedicare una certa quantità di memoria VRAM della vostra scheda video per alleggerire il carico sulla ram e accelerare la velocità di generazione del testo.

KoboldCPP fa uso dei modelli convertiti in GGML, ecco una lista di modelli Llama 2 per GGML, in genere il modello 7B (7 miliardi di parametri) richiede circa 6-8 GB di ram mentre il modello 13B richiede circa 9-12 GB di ram, i modelli ancora più grandi richiedono enormi quantità di memoria ram.

Meta ammette che Llama 2 presenta alcuni bias e bias tossici, ma sta lavorando per minimizzarli tramite servizi di sicurezza. In definitiva, Meta incoraggia l’uso responsabile di Llama 2 e chiede agli utenti di rispettare i termini della licenza e le linee guida di utilizzo accettabile.